De toepassing van Large Language Models zoals ChatGPT heeft zo’n hoge vlucht genomen, dat we bijna zouden vergeten dat er ook nog andere typen AI zijn. Wat gaat de toekomst van AI ons brengen?

We zetten ze steeds vaker in als handige hulpjes die rapporten samenvatten, e-mails opstellen, computercodes kloppen en wat al niet meer. Large Language Models (LLM’s) zijn zogenaamde ‘neurale netwerken’: computermodellen die zijn geïnspireerd op de werking van het menselijk brein. Ze vinden patronen in enorme hoeveelheden geschreven of gesproken tekst. Op basis daarvan berekenen ze de kans dat een bepaald woord binnen een bepaalde context kan volgen op een ander woord en dat die woorden samen een plausibel antwoord zouden kunnen vormen op een specifieke vraag. LLM’s zijn echter niet het enige type artificiële intelligentie. Welke ontwikkelingen op AI-gebied verdienen nog meer onze aandacht?

Minder regelknoppen

Dat het vakgebied zo’n vlucht heeft genomen, had van tevoren niemand voorzien, vertelt LLM-onderzoeker Antal van den Bosch van de Universiteit Utrecht. “Zo’n zeventig, tachtig jaar geleden begonnen mensen zich bezig te houden met kunstmatige intelligentie. Wat is er nodig om de hogere functies van het menselijk brein te laten overnemen door computers? Die computer moet kunnen leren, kennis representeren, redeneren, plannen en eventuele sensoren van een robot moet je managen. Een klein stukje hield zich bezig met taal.” Dat dit kleine stukje zo overheersend zou worden, komt door de komst van het internet en daarmee de beschikbaarheid van enorme hoeveelheden gesproken en geschreven tekst om de modellen op te trainen. Snelle ontwikkelingen in de chip- en gamingindustrie voegden de nodige rekenkracht toe. Neurale netwerken als LLM’s en allerlei beeldanalysesystemen konden daardoor razendsnel worden opgeschaald.

De Graphics Processing Unit (GPU), ook wel bekend als de grafische kaart van een computer, is de rekenkrachtpatser achter AI.

Thomas Foster, via UnsplashInmiddels is duidelijk dat LLM’s ook de nodige beperkingen en zelfs nadelen hebben. Zo kost met name het trainen van de modellen erg veel energie. Dat heeft te maken met het aantal parameters: de ‘regelknoppen’ waarmee het programma zo kan worden afgesteld, dat het goed functioneert. Hoe meer parameters, des te meer knoppen om het LLM mee te verfijnen. “ChatGPT5 heeft ongeveer 1,7 triljoen parameters”, zegt Eric Postma, hoogleraar AI aan Tilburg University. “Dat is een enorm aantal en het kost erg veel energie om aan al die knoppen te rekenen. Er is momenteel enorm veel onderzoek gaande om te kijken hoe we die modellen simpeler kunnen maken. Het idee is dat het aantal parameters moet kunnen worden teruggebracht, alleen weten we nog niet hoe.”

Compacte modellen en multi-agents

Wat de LLM’s ook parten speelt, is dat ze erg onnavolgbaar zijn. Dat maakt ze voor bepaalde toepassingen riskant: het is wel zo fijn om te weten waaróm een computermodel tot een juridische uitspraak, of een medische diagnose komt. “Mensen spreken vaak over ‘black box’, maar eigenlijk is een LLM eerder een ‘grey box’”, zegt Postma. “We begrijpen goed hoe de modellen werken, alleen zijn ze zo omvangrijk en complex in termen van aantallen parameters, dat het heel moeilijk is om dat samen te vatten.”

Op beide gebieden zijn momenteel veel ontwikkelingen gaande. Zo lanceerde een Chinees bedrijf, Hangzhou DeepSeek AI Basic Technology Research, in januari dit jaar een goed presterend LLM dat is getraind voor een fractie van de kosten van ChatGPT. “Ze hadden een truc gevonden om het model compacter te maken”, zegt Van den Bosch. “Je zou het model kunnen zien als een spons waar ze de lucht uithalen. Niet productieve stukjes model halen ze eruit, waardoor het model kleiner wordt en minder energie gebruikt.”

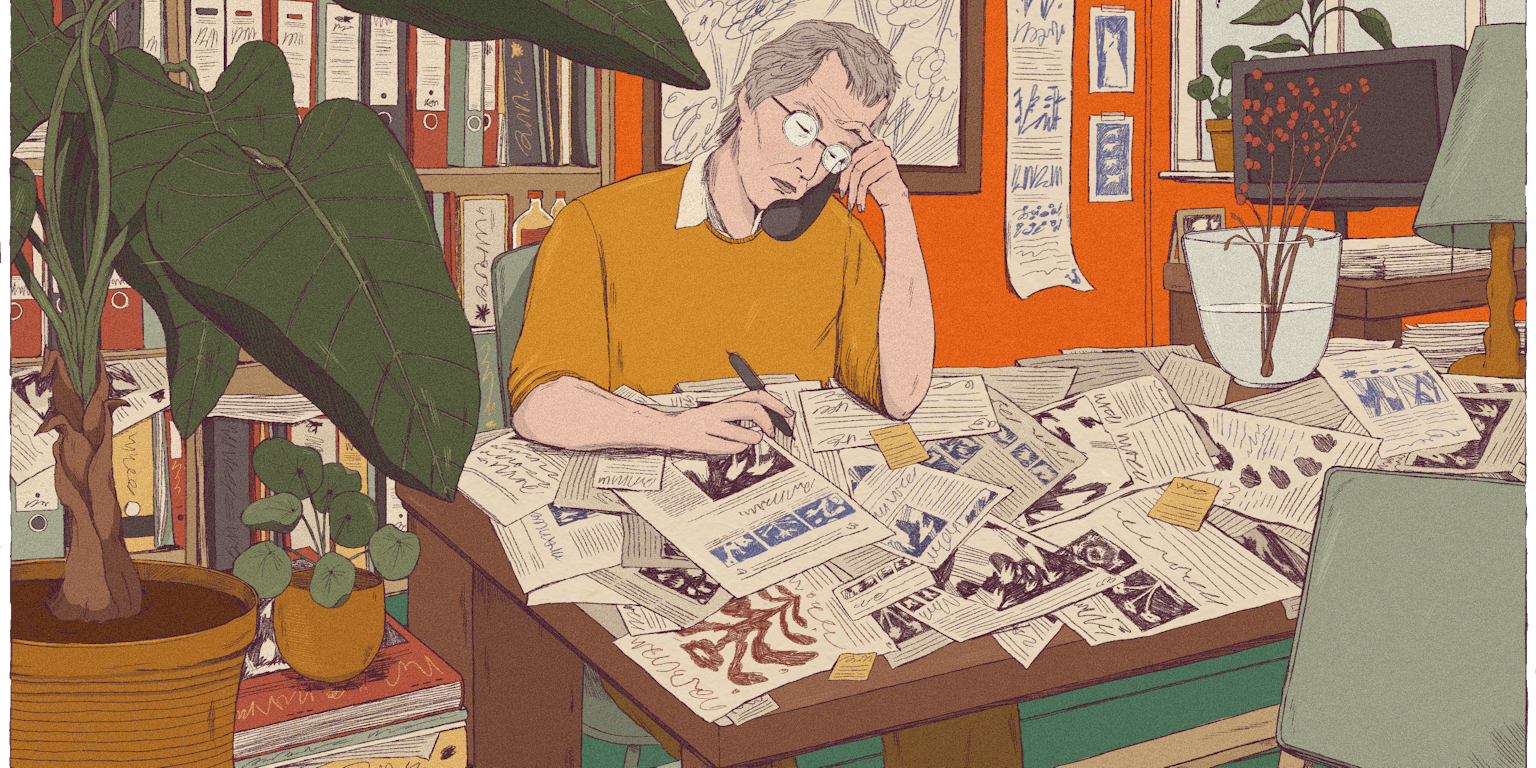

Een andere ontwikkeling die in potentie zowel de energiezuinigheid als de transparantie ten goede komt, is de inzet van ‘agents’. Verschillende intelligente eenheden (‘agents’) werken daarbij als team samen aan een opdracht. Van den Bosch: “Joris Verbeek, een PhD-student van me, heeft bijvoorbeeld een soort newsroom gemaakt van LLM’s die ieder voor zich een specifieke taak uitvoeren: je hebt een analyst die gegevens koppelt en checkt, een reporter die het artikel schrijft en een redacteur die de nieuwswaardigheid inschat.” Mits de verschillende AI’s slim op elkaar zijn afgestemd en zo klein mogelijk zijn, levert dat in potentie voor minder energie sneller resultaten op die ook nog betrouwbaarder én navolgbaar zijn.

Een snufje logica

LLM’s hebben echter beperkingen die nog fundamenteler van aard zijn dan het energieverbruik. Virginia Dignum, hoogleraar Computer Science aan de Universiteit van Umeå (Zweden), illustreert dit met een absurd voorbeeld. “Wil je weten hoe zwaartekracht werkt? Gooi miljarden pingpongballen uit het raam en maak daar video-opnamen van. Voer die video’s vervolgens aan een zelflerend algoritme en kijk of die met een zwaartekrachttheorie op de proppen komt.” Wat Dignum met het voorbeeld wil zeggen: we moeten de kracht van LLM’s niet overschatten. “We gaan er nu te veel vanuit dat menselijke expertise niet meetelt. Alleen wat data zegt, telt. Ik zeg niet dat de technieken die we nu gebruiken niet handig zijn, maar we zijn te exclusief op die data gericht.”

— Eric Postma

Dat was ooit wel anders. Decennialang hebben onderzoekers en ontwikkelaars geprobeerd kunstmatige intelligentie te ontwikkelen op basis van logische regels, die weer voortkomen uit menselijke expertise. De schaakcomputer is daarvan een klassiek voorbeeld, dat voor een spelletje schaak uitstekend werkt: in scenario X zet je het paard naar positie Y. Voor complexere opdrachten is deze aanpak niet geschikt, omdat we onmogelijk alle menselijke kennis in een computerprogramma kunnen stoppen.

Een schaakcomputer is een klassiek voorbeeld van een kunstmatige intelligentie, gebaseerd op een set logische regels: in scenario X zet je het paard naar positie Y. Prima voor een uitdagend potje schaak, maar totaal niet toereikend voor complexere opdrachten.

Urszula, via PixabayEen nieuw type AI dat nu in opkomst is, zogenaamde ‘neurosymbolische AI’, combineert beide aanpakken. “De Israëlisch-Amerikaanse psycholoog Daniel Kahneman stelde dat mensen 95 procent van de tijd snelle, onbewuste, intuïtieve beslissingen nemen en 5 procent van de tijd hun langzame, bewuste, redeneervermogen gebruiken”, vertelt Postma. LLM’s lijken het meest op het snelle systeem en zouden beter kunnen presteren met de logica van het langzame systeem. “LLM’s zijn statistische machines die het volgende woord kunnen raden en zo een conversatie kunnen hebben, maar in sommige domeinen gelden harde regels en is redeneren noodzakelijk. Daarom probeert men nu het redeneervermogen van LLM’s te verbeteren.”

Holistische aanpak

Hoe succesvol kunstmatige intelligentie in de toekomst zal zijn, hangt niet alleen af van welk type AI sneller, energiezuiniger, of slimmer is. Minstens zo belangrijk is hoe we AI weten in te passen binnen een menselijke context, zegt Dignum. “Voordat je AI inzet, zijn bepaalde uitgangsvragen belangrijk. Moeten we voor dit probleem wel AI gebruiken? Wat winnen we daarmee en wat verliezen we? En wie moet betrokken zijn bij die beslissing?”

Al aan het begin van haar carrière, ongeveer twintig jaar geleden, leerde Dignum dat een technische oplossing in de praktijk heel anders kan uitwerken dan op papier. In opdracht van een grote verzekeraar hielp ze een algoritme te ontwikkelen dat helpdeskmedewerkers konden gebruiken om schadevergoedingen sneller af te handelen. Hoewel het algoritme goed werkte, werd het nauwelijks gebruikt.

“Die mensen zaten allemaal in dezelfde zaal vragen te beantwoorden van klanten met schade. Als je een expert bent, bijvoorbeeld op het gebied van caravans met een rieten dak, en er komt ergens een vraag binnen over zulke caravans, dan staat zo’n helpdeskmedewerker op en loopt even naar je toe voor overleg. Als het antwoord in een expertsysteem staat, komt niemand meer naar jouw bureau toe. Dan zit je alleen maar de hele dag aan de telefoon. Ze misten dat menselijke contact.”

Als het aan Elon Musk lag, werd elke Amerikaanse rechter vervangen door AI. Maar AI is zeker geen antwoord op alles. Bij elke toepassing moeten we ons blijven afvragen of we dit wel moeten willen.

Ray_Shrewsberry, via Pixabay.Ook een meer recent voorbeeld, de toeslagenaffaire, illustreert hoe een algoritme uitstekend kan doen wat je het opdraagt, maar toch desastreuze gevolgen kan hebben. “Het belangrijke besef groeit dat AI-oplossingen niet alleen maar technische oplossingen zijn”, zegt de hoogleraar. “In een slecht georganiseerde omgeving heb je niets aan een algoritme. Ingenieurs houden zich niet erg bezig met de waarom-vraag. Er is een probleem en dat ga je oplossen. Maar waarom is iets een probleem en voor wie? Wie gaat baat hebben bij de oplossing, wat voor maatschappelijke verandering kan de oplossing teweegbrengen?”

— Virginia Dignum

Dignum pleit daarom voor een ‘holistische aanpak’, wat erop neerkomt dat ingenieurs en ontwikkelaars, maar ook beleidsmakers vaker te rade gaan bij experts uit andere disciplines, gebruikers en belanghebbenden. En wellicht leidt dat dan tot de vaststelling, dat AI helemaal geen oplossing voor het probleem is. “Er is heel erg een idee ontstaan dat AI alles gaat oplossen en dat je verkeerd bezig bent als je geen AI gebruikt. In plaats van als een kip zonder kop achter de ontwikkelingen aanrennen, zou het goed zijn om vaker een stap terug te nemen en ons af te vragen: willen we dit doen, of niet?”