Wetenschappers en bedrijven doen veel onderzoek naar robots die emoties kunnen herkennen. “In laboratoria werkt alles vaak perfect, maar in onvoorspelbare situaties is het vreselijk ingewikkeld.”

Ich bin dein Mensch (I’m your man) is een sciencefictionfilm uit 2021. Wetenschapper Alma doet daarin mee aan een experiment, waarin ze drie weken lang doorbrengt met haar ‘ideale man’: Tom, een robot (hoewel gespeeld door een mens). Het leidt tot hilarische situaties. Tom voelt situaties niet goed aan: bij hun eerste ontmoeting geeft hij Alma een handzoen. Tijdens een etentje vleit hij haar met zoetsappige teksten: ‘Je ogen zijn als twee bergmeren waarin ik verdrink.’ De nuchtere wetenschapper krijgt er, getuige haar gezicht, de kriebels van. Meer ongemak volgt als Tom voor haar een bad maakt met champagne, kaarsen en rozenblaadjes. ‘93 procent van de Duitse vrouwen houdt hiervan’, zegt Tom. Het antwoord van Alma: ‘En raadt eens tot welke groep ik behoor?’

De robot is voorgeprogrammeerd aan de hand van tests die bij Alma zijn afgenomen. ‘Ze testten me, scanden mijn brein en namen eindeloos surveys bij me af. En wat is het resultaat?’, vraagt ze zich vertwijfeld af. Hoewel fictie, laat de film goed zien hoe complex menselijke emoties zijn – en hoe moeilijk het is voor robots om daarop in te spelen.

Danswereld

Robots herkennen emoties op een soortgelijke manier als mensen, vertelt robotonderzoeker Marieke Van Otterdijk van de Vrije Universiteit Amsterdam. Ze nemen informatie waar, interpreteren en proberen er gepast op te reageren. “Robots die emoties moeten herkennen, worden gevoed met grote hoeveelheden onderzoeksdata.” Die kunnen bestaan uit beelden, geluid, tekst en fysiologische gegevens. Zo kunnen camera’s emoties op gezichten en de lichaamshouding waarnemen. Op basis van de positie van schouders, armen of romp kan software afleiden hoe iemand zich voelt. “Theorieën uit bijvoorbeeld de danswereld helpen daarbij. Zo wijst een open houding met uitgestrekte armen op opwinding, die zowel positief als negatief kan zijn”, vertelt Van Otterdijk.

Naast visuele input maken robots ook gebruik van audio. Ze analyseren stemgeluid op toonhoogte, volume, spreeksnelheid en trillingen. Ook vinden er experimenten plaats met fysiologische data, zoals hartslag, zweet, spierspanning en hersenactiviteit, die iets kunnen zeggen over emoties bij een persoon. Een simpel voorbeeld: een hoge hartslag en zweten kunnen erop duiden dat iemand angstig is. Sommige methoden, zoals het meten van hersenactiviteit via een kap die lijkt op een badmuts, zijn minder praktisch in reallife settings.

Gesimuleerde setting

Om robots emoties te laten interpreteren gebruiken onderzoekers psychologische modellen. Een voorbeeld van zo’n psychologisch model zijn de zes basisemoties van onderzoeker Paul Ekman: woede, angst, afschuw, geluk, verdriet en verrassing. Er is daarbij één grote uitdaging: de gebruikte data komen meestal uit labomgevingen. Proefpersonen bevinden zich in een gesimuleerde setting, bijvoorbeeld met camera’s en microfoons, en krijgen de opdracht om een gesprek te voeren. Soms proberen onderzoekers spontane emoties op te wekken, met hulp van acteurs. “In laboratoria werkt alles vaak perfect, maar robots in het wild in onvoorspelbare situaties laten functioneren, is vreselijk ingewikkeld”, aldus Van Otterdijk.

Haar collega-wetenschapper Khiet Truong van de Radboud Universiteit Nijmegen en de Universiteit Twente is het met dat laatste zeer eens. Ze is dan ook kritisch over bedrijven die nu al claimen dat hun systemen emoties kunnen herkennen. “In de praktijk vereist emotieherkenning nuance en context. Emotieherkenning is namelijk sterk afhankelijk van de situatie. Culturele en individuele verschillen spelen een grote rol. Daarom is het erg lastig en misschien zelfs onmogelijk dat we ooit een systeem bouwen dat universeel emoties kan herkennen”, aldus Truong.

Zonder context zijn gezichtsuitdrukkingen lastiger te interpreteren.

Freepik/BillionPhotosOm dat te illustreren haalt ze een ‘klassiek voorbeeld’ uit gezichtsuitdrukkingsonderzoek aan. Deelnemers aan het onderzoek kregen een foto te zien van een hoofd met een frons en een boze blik. Ze moesten de emoties van deze persoon inschatten. “Zo’n foto kan je zien als een kader waarin iets gebeurt. In isolatie lijkt de persoon boos. Zodra je de context ziet, namelijk een hordeloopwedstrijd, verandert je hele interpretatie.”

Melancholie

Robots kunnen wel meetbare signalen analyseren, zoals toonhoogte of spieractiviteit, maar het is moeilijk om daaruit met zekerheid emoties af te leiden. “En zelfs als mijn mondhoeken omhooggaan, betekent dat niet per se dat ik blij ben.” Dat is nog niet alles, vervolgt ze. Subtiele of gemengde emoties, zoals melancholie of nostalgie, zijn voor een machine extreem moeilijk te interpreteren. Ook emoties die bewust onderdrukt of gemaskeerd worden, blijven lastig. “Een robot zal daarom waarschijnlijk nooit álle emoties accuraat kunnen herkennen.”

— Khiet TruongHet kan mensen helpen, maar lost de oorzaak van het probleem niet op

Als een robot nóóit accuraat emoties zal gaan herkennen, dan houdt dat automatisch in dat ie altijd fouten zal maken. Dat is ook de Europese wetgevers niet ontgaan. Truong vertelt dat de EU AI Act, een Europese wet voor het veilig en verantwoord ontwikkelen en gebruiken van kunstmatige intelligentie, gebruik van emotieherkenning in het onderwijs verbiedt. Truong vindt dat logisch. “Er is al veel onderzoek gedaan naar robots die leerlingen in klaslokalen ondersteunen met leren. Stel dat die in de toekomst bepalen hoe een kind emotioneel in elkaar zit en op basis daarvan een leerprogramma samenstellen. Als daar grove fouten gemaakt worden, dan heeft dat zeer negatieve gevolgen voor het leerproces van het kind.”

Sociaal isolement

Truong en Van Otterdijk verwachten dat grote spelers in de techwereld verder zullen investeren in emotieherkenning, zeker in de zorg. Daar ligt de focus onder meer op het herkennen van stemmingsstoornissen, zoals depressie of bipolaire stoornissen, via fysiologische gegevens. Truong: “Denk aan slimme armbanden die de opwinding in het lichaam meten, of gegevens uit smartphones, zoals beweging, hartslag en spraak. Je kunt ook patronen detecteren van weinig beweging of afwijkend slaapgedrag. Als je dergelijke informatie combineert, zie je mogelijk tekenen van mentale problemen.”

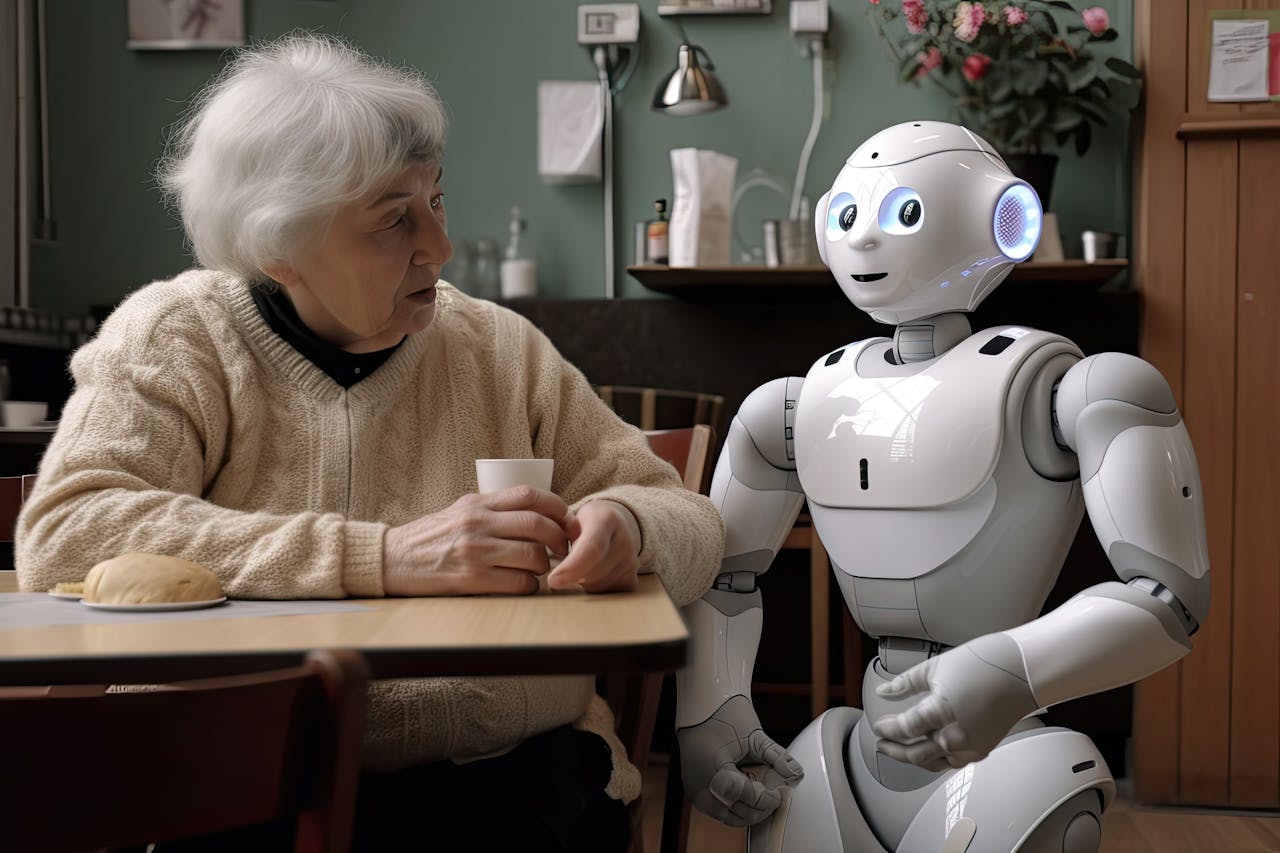

Er zijn ook chatbots en virtuele gezelschapbots die reageren op emoties. Zo zijn er al chatbots die empathisch lijken te reageren en bedoeld zijn om eenzaamheid te verlichten. Truong: “Aan de ene kant is dat technisch indrukwekkend en kan het mensen helpen. Aan de andere kant lost het de oorzaak van het probleem niet op.”

Een robot houdt een oudere dame gezelschap.

FreepikVan Otterdijk denkt niet dat mensen zoveel van robots gebruikmaken dat ze steeds minder in contact met elkaar komen en er een sociaal isolement ontstaat. “Mensen hebben zelf de regie en ik merk dat er brede consensus is: we vinden echt contact met andere mensen nog altijd veel waardevoller. Dat zal in de nabije toekomst niet veranderen.” Bovendien moet de techniek dan nog enorme sprongen maken. “In het sciencefictiongenre werd decennia geleden voorspeld dat in het jaar 2020 robots dominant zouden zijn in onze samenleving. Robots zijn, als partner in emotionele interactie, daarvoor simpelweg nog niet ontwikkeld genoeg.”