Gay-dar: de veronderstelde mogelijkheid om te detecteren of iemand homoseksueel is op basis van non-verbale signalen. Onderzoekers Michal Kosinsku en Yilun Wang van de Universiteit van Stanford hebben een kunstmatige intelligentie getraind dit beter te doen dan mensen. Wordt de privacy van onze seksuele geaardheid bedreigd?

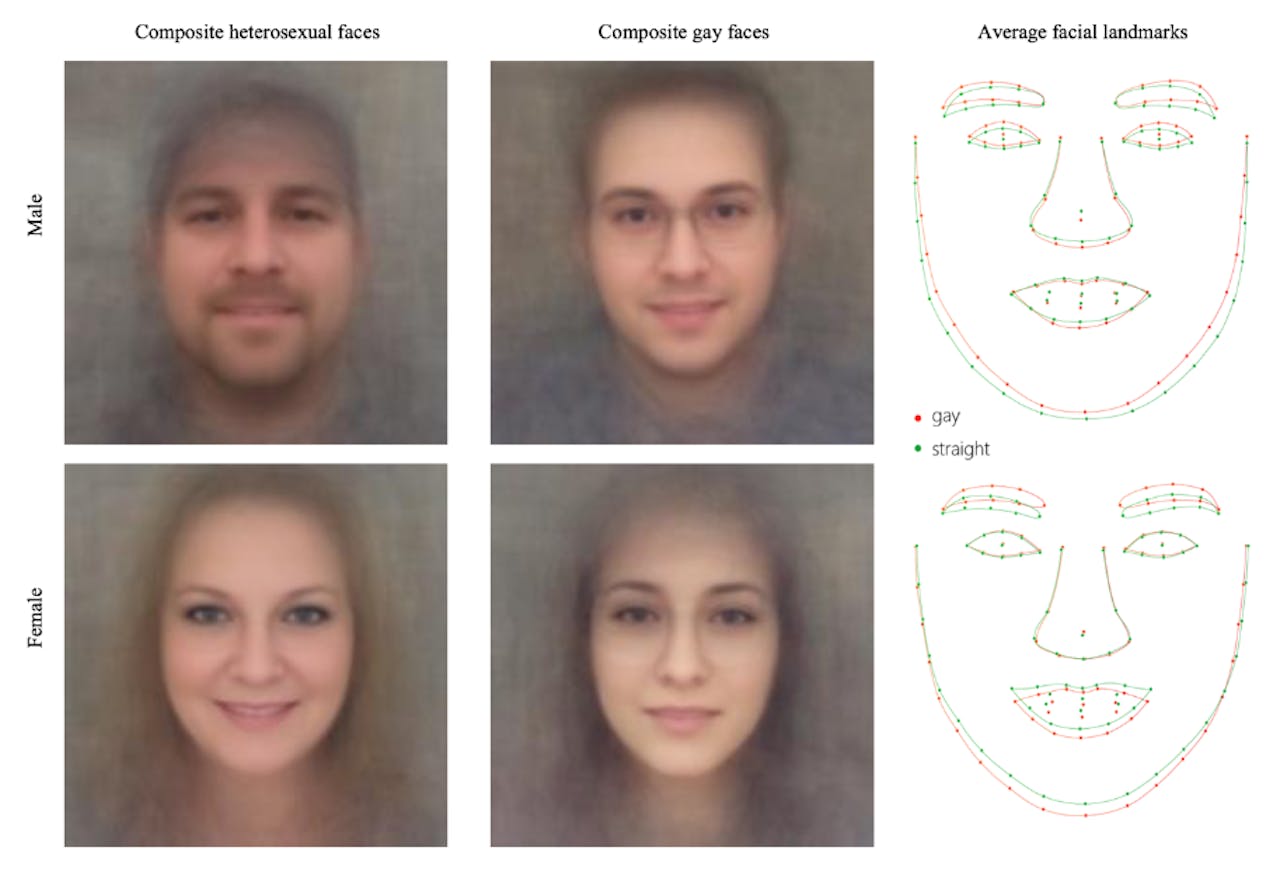

Michal Kosinsku en Yilun Wang, beiden onderzoekers aan de Universiteit van Stanford, hebben een kunstmatige intelligentie getraind de seksuele geaardheid van een persoon te voorspellen op basis van een aangezichtsfoto. De kunstmatige intelligentie baseert haar oordeel op zowel primaire gezichtskenmerken, waaronder de grootte van de kaak, neuslengte, de grootte van het voorhoofd, als op secundaire kenmerken zoals verzorging en haarstijl.

Compositie van hetero gezichtskenmerken ten opzichte van homoseksuele gezichtskenmerken, afkomstig uit het onderzoek van Kosinsku en Wang.

Kosinski, M., & Wang, Y. (2017). Deep neural networks are more accurate than humans at detecting sexual orientation from facial images.Op basis van één foto kan de kunstmatige intelligentie de seksuele geaardheid correct voorspellen bij 81% van de mannen en 71% van de vrouwen. Bij het zien van vijf foto’s van dezelfde persoon ligt dat percentage zelfs nog hoger: 91% bij mannen en 83% bij vrouwen. Het onderzoek toont aan dat de resultaten van menselijke keuzes veel lager liggen. Mensen voorspellen slechts 61% juist bij mannen en 54% juist bij vrouwen.

Impact van het onderzoek

Dat kunstmatige intelligentie op basis van gezichtskenmerken de seksuele geaardheid van mensen kan voorspellen heeft grote impact op de privacy en veiligheid van de LGBTQ-gemeenschap, zoals Kosinsku en Wang zelf ook aangeven in hun onderzoek. In hun Authors’ note staat dat ze zelf geschokt zijn van het resultaat en twijfelden om dit te publiceren. De reden dat zij het onderzoek toch publiceren is om de LGBTQ-gemeenschap te waarschuwen voor de risico’s die deze techniek met zich mee zou kunnen brengen.

Gert Hekma, voormalig docent homo- en genderstudies aan de Universiteit van Amsterdam, ziet desgevraagd geen risico’s in het onderzoek van Kosinsku en Wang. Hij gelooft niet in de biologische verklaring voor homoseksualiteit. “Het lijkt mij een fake-theorie waar hetero’s erg opgewonden van worden”, meldt Hekma via e-mailcontact, “seks is variëteit”. De factoren die volgens Hekma invloed hebben op seksuele geaardheid van mensen zijn onder andere ouders, media, vrienden en school. “Ik denk dat seksuele voorkeuren vroeg in de jeugd ontstaan, maar niet helemaal vastliggen”, aldus Hekma.

“Ik zag dat de politie en justitie stomme, medische theorieën gebruikten tegen homo’s in Egypte en ook in Tsjechië”, schrijft Hekma, “maar ze hadden de homo’s toen al te pakken en mishandelden ze al voor ze die theorieën gebruikten.” Kunstmatige Intelligentie zal geen verandering brengen in hoe homoseksuelen in sommige landen worden behandeld.

Prof. dr. Pieter Ippel, professor Rechten aan University College Roosevelt, denkt daar anders over. Volgens hem zouden sommige overheden en bedrijven wel degelijk belang kunnen hebben bij deze technologie om homoseksuelen te kunnen herkennen of op te sporen. In sommige landen en culturen wordt homoseksualiteit als een strafbaar feit gezien, en in het ergste geval is doodstraf het gevolg.

Maar ook in westerse landen, waar je openlijk homoseksueel kunt zijn, kan er sprake zijn misbruik. “Zorgverzekeraars kunnen homoseksuelen als een risicogroep voor bepaalde ziektes zien”, vertelt Ippel, “Een ander voorbeeld van discriminatie is dat heteroseksuele studenten hogere cijfers zouden kunnen krijgen tegenover homoseksuele studenten, op basis van hun studentfoto.” Volgens Ippel is het goed mogelijk dat door deze Kunstmatige Intelligentie een nieuwe vorm van zal discriminatie ontstaan.

Tolerantie tegenover homoseksualiteit is nog niet overal in de wereld te vinden.

Pixabay, janeb13 via CC0Kanttekeningen bij het onderzoek

Misschien klinkt het ook allemaal wel ‘enger’ dan het is; er zijn namelijk wel een aantal kanttekeningen te plaatsen bij dit onderzoek. Zo is het onderzoek alleen gebaseerd op foto’s van blanke, Amerikaanse mensen. Het is niet zeker of de resultaten in andere delen van de wereld net zo nauwkeurig zijn. Ook focust het onderzoek enkel op het onderscheid tussen hetero- en homoseksuelen, terwijl er meer vormen van seksuele geaardheid bestaan. En dan is er nog de vraag in welke mate seksuele geaardheid aangeboren, en dus zichtbaar, is in uiterlijke kenmerken.

Je foto op sociale media verspreidt over de hele wereld. Baart dit je zorgen met oog op deze Kunstmatige Intelligentie?

Pixabay, Gerd Altmann via CC0Ippel stelt desalniettemin dat we altijd kritisch moeten blijven tegenover dit soort technologieën. Er is nog geen sprake van honderd procent nauwkeurigheid, dus hoe betrouwbaar kunnen we ons baseren op het oordeel van de computer?

“Volgens de huidige privacy-wet”, vertelt Ippel, “moet zulke kunstmatige intelligentie goed worden verantwoord voordat het gebruikt mag worden”. Daarbij moet niet alleen het doel van het gebruik worden verantwoord, maar vooral waarom het rechtvaardig is om te gebruiken. Ippel stelt dat het bij deze kunstmatige intelligentie zeer lastig zal worden dit te rechtvaardigen. Mensen zouden bij dit soort onderzoek ook een duidelijk onderscheid moeten maken tussen wat we kunnen en wat we daarvan willen toepassen.

Een dergelijk voorbeeld is het ontwikkelen van nucleaire wapens. We weten wel hoe we ze moeten maken, maar we moeten het niet willen. “Dat is hetzelfde met deze Kunstmatige Intelligentie”, zegt Ippel. “Daarnaast zouden we moeten nadenken of het niet belangrijker is onze tijd en ons geld in ander onderzoek te steken. Onderzoek naar klimaatproblemen of naar de genezing van ziektes is veel belangrijker dan dit.”