Met deepfakes kun je in video’s iedereen álles laten zeggen. Het is de ultieme fopvorm. Kunnen we dan niets meer vertrouwen van wat we zien? Er blijkt minder mogelijk dan veel mensen denken, en deepfakes hebben ook nuttige toepassingen.

Tom Cruise likt aan een lolly. Terwijl hij een van zijn populaire TikTok-video’s opneemt, ligt hij in het gras en verbaast zich erover dat er in zijn lolly een kauwgom zit. In een andere video slaat Cruise een golfbal, doet een goocheltruc met een muntje en struikelt over een tapijt. Waarom trekt hij met deze onbenullige video’s miljoenen kijkers? Simpel: het is Tom Cruise niet.

Deze video is een zogenoemde deepfake (een samentrekking van deep learning en fake) van de Vlaamse video-artiest Chris Umé, die hij op het profiel DeepTomCruise de wereld in slingert. Andere populaire deepfakes waren die van Barack Obama en imitator Jim Meskimen. Ook in ons eigen land maakten de nepvideo’s furore, zoals minister Grapperhaus die een dartpartij nabeschouwt of overleden dierbaren waarmee mensen bij wijze van experiment tijdens rouwtherapie kunnen praten.

Een greep uit de video’s van het TikTok-account DeepTomCruise.

De reacties op dit soort video’s zijn verdeeld. Zo klinkt er niet alleen vanuit therapeuten, maar ook vanuit de filmwereld enthousiasme over de mogelijkheden. Nasynchronisatie in verschillende talen of opnames met bekendheden op afstand leveren geen problemen meer op. Mensenrechtenorganisaties en politici zijn echter bezorgd en roepen zelfs om een verbod. Welke soorten deepfakes zijn er en hoe worden ze gemaakt? Kunnen we straks niet meer controleren wie wat gezegd heeft, of kunnen we ermee leren leven?

Een waaier aan fopmiddelen

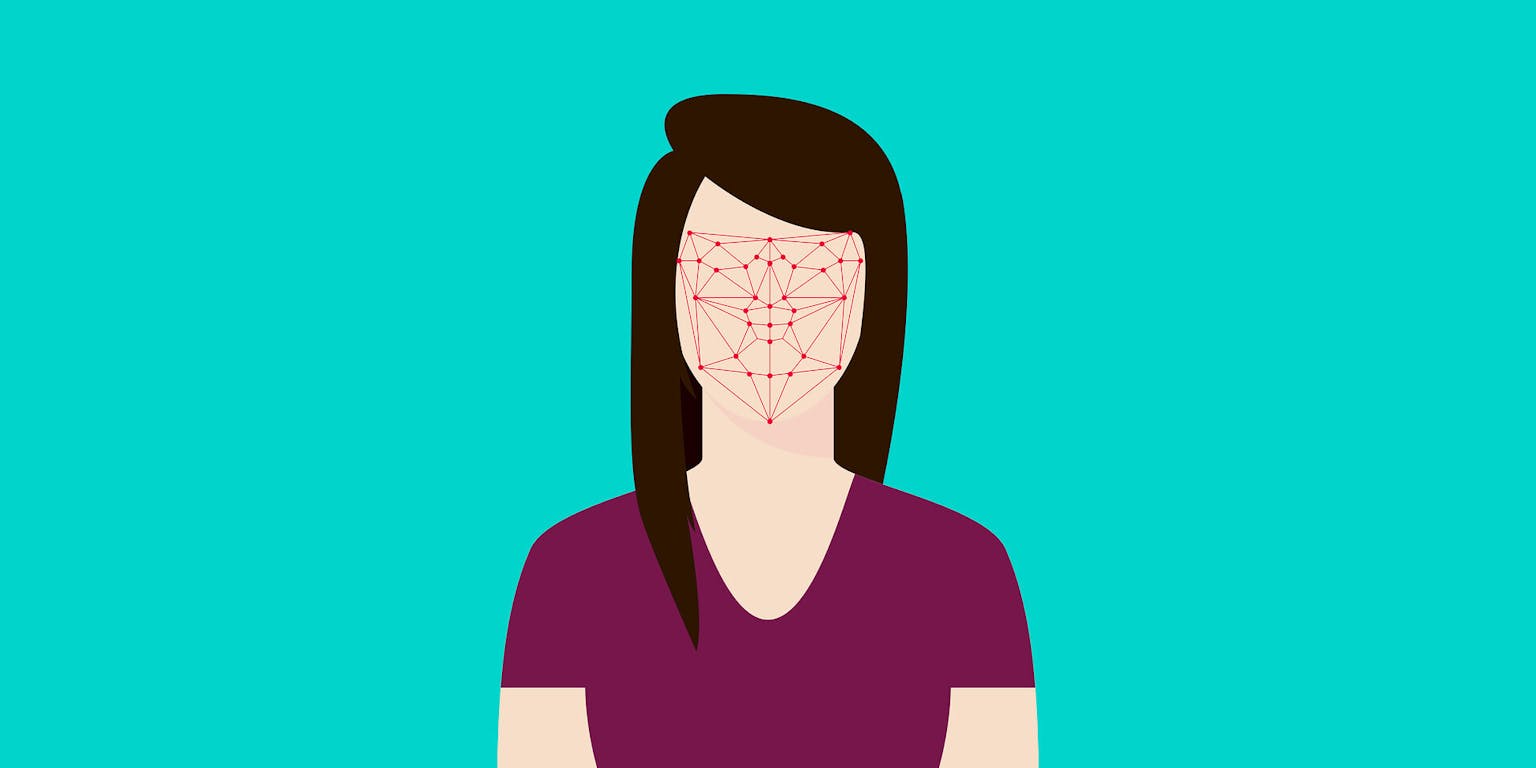

Er zijn een hoop verschillende manieren om de boel te neppen in een filmpje. De simpelste manier is wellicht het vervormen van een stilstaand beeld van een gezicht – vaak met de Engelse term ‘morph’ aangeduid. De computer ‘trekt’ hierbij aan punten in een stilstaand beeld, waardoor het lijkt alsof de persoon op de foto beweegt of iets zegt. Dat ziet er niet bepaald realistisch uit, zoals in deze video van de popgroep Vengaboys te zien is, maar je hebt er weinig rekenkracht voor nodig. Volgens Theo Gevers, professor computer vision van de Universiteit van Amsterdam, kan deze technologie op ieder gezicht toegepast worden zonder uitgebreide training van een computermodel (zie ook kader Deeplearning is essentieel). Er zijn apps waarmee je zelf dit soort filmpjes op je telefoon kunt maken.

Voor een zogenoemde face sync moet wél voor ieder persoon een apart computermodel worden getraind. De basis hiervoor is doorgaans een video van de persoon in kwestie. Gevers: “Onder de motorkap maakt de computer in feite aan de hand van een tweedimensionaal beeld een driedimensionaal model van het gezicht.” Het opbouwen van het model kost relatief veel rekenwerk, maar daarna is het vrij eenvoudig om de deepfake van deze persoon alles te laten zeggen. De deepfake kan dan zelfs live worden aangestuurd door een acteur van wie de gezichtsbewegingen worden overgenomen. Zo’n model kent grenzen: wanneer een acteur bijvoorbeeld een zittende Donald Trump aanstuurt dan is het niet mogelijk deze te laten opstaan en een radslag te laten maken.

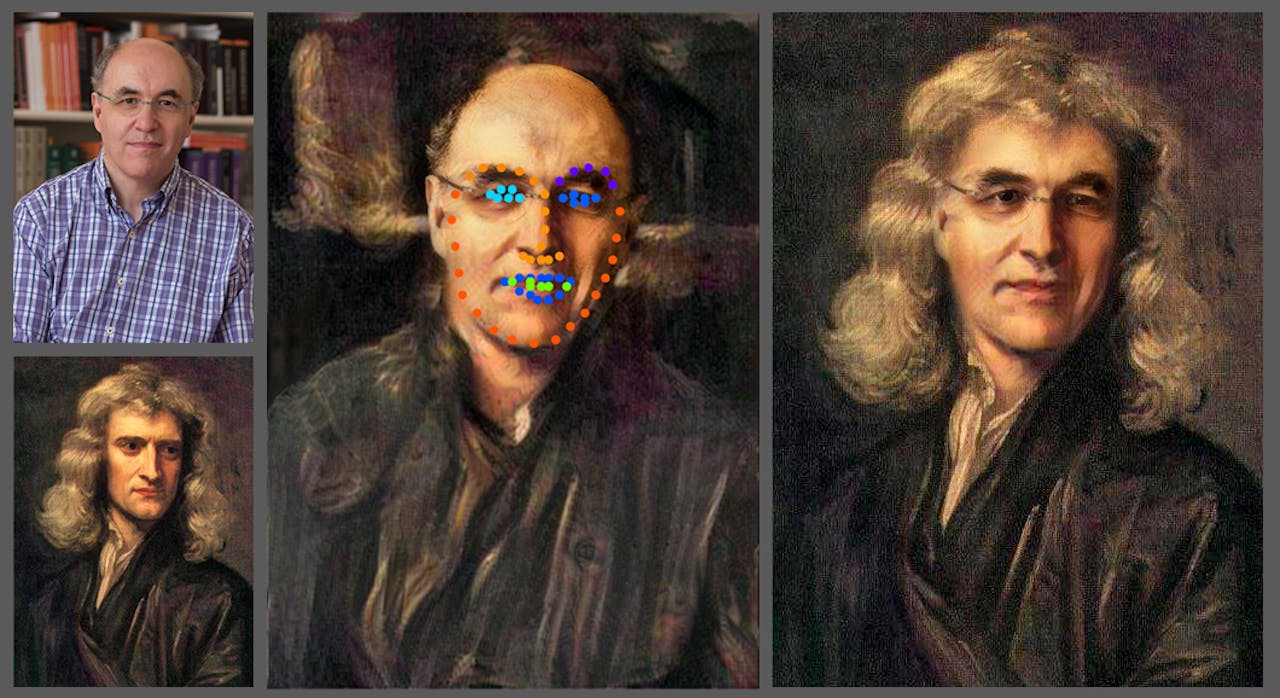

Een face swap waarbij het gezicht van de Britse natuurkundige Stephen Wolfram op het hoofd van Isaac Newton is geplakt.

Wikimedia commons, Stephen Wolfram via CC BY-SA 4.0Een methode die je wel de vrijheid geeft om een deepfake vrijwel alles te laten zeggen én doen, is de zogenoemde face swap. Hierbij wordt een gezicht op het hoofd van een acteur geplakt – dit gebeurde in de video’s van DeepTomCruise. Het is waarschijnlijk de meest gebruikte deepfake-methode. Gevers legt uit: “Stel je wilt Robert De Niro zijn, dan trek je zijn kleren aan en plak je daarna een model van het gezicht van De Niro op jouw hoofd. Je moet zijn stem wel goed na kunnen doen, daarom gebruikt men vaak stemacteurs.” Computers kunnen ook steeds realistischer stemmen nabootsen. Bij een face swap is volgens Gevers nog wel ‘handenarbeid’ nodig, evenals bij de head en body swap waarbij een hoofd respectievelijk lichaam wordt vervangen. Op dit moment is het niet mogelijk om live een face swap te doen.

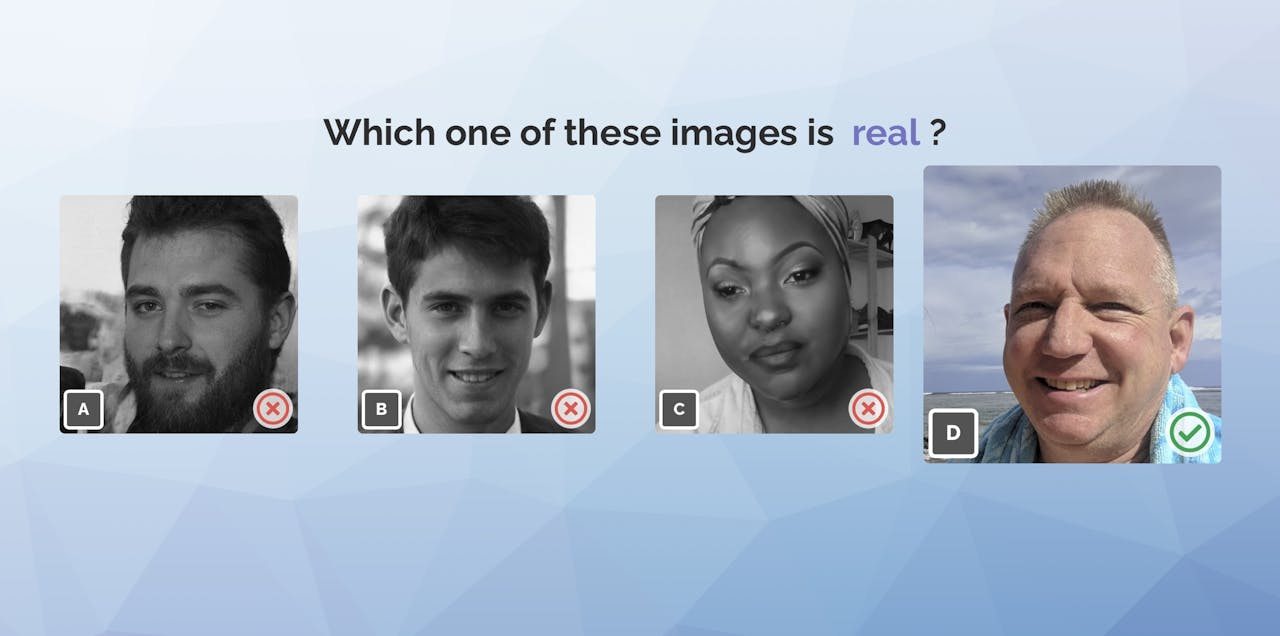

Met deeplearning kun je niet alleen gezichten verwisselen, maar ook geheel ‘nieuwe personen’ maken. Het bedrijf 3DUniversum, Gevers’ spin-off, doet dat voor bedrijven. Zij gebruiken de niet-bestaande mensen voor beelden op hun website of voor het tonen van kleding. Volgens Gevers biedt dit verschillende voordelen. Het is zo makkelijker om inclusiviteit te creëren en je hoeft niet te denken aan de privacy van modellen, zegt hij. De algoritmes zijn getraind met een grote hoeveelheid bestaande gezichten en maken fotorealistische nepgelaten. Het succes blijkt uit een quiz op de website van het bedrijf, waarin je in twaalf rondes moet bepalen of gezichten echt of nep zijn. Volgens de makers voltooit minder dan 0,13 procent van de deelnemers deze quiz zonder fouten.

3DUniversum ontwikkelt algoritmes die gezichten ‘fabriceren’. Van deze vier gezichten is er maar één echt. Op de website van het bedrijf kun je een quiz maken en raden welke gezichten echt en nep zijn.

3DUniversum met toestemmingGrapjas in een badjas

Door de soms hyperrealistische deepfake-video’s die verschijnen, ontstaat er nogal eens verwarring over wat er nu wel en niet mogelijk is met deze techniek. Er zijn (nog) beperkingen. Volgens Gevers is het op dit moment bijvoorbeeld niet mogelijk om live een realistische face swap uit te voeren, waarbij het gezicht van iemand op dat van een ander wordt geplakt. Een rechtstreekse face sync kan wel, waarbij het gezicht van iemand ‘gestuurd’ wordt. De acteur die het gezicht bestuurt kan het lichaam van de persoon dan alleen niet besturen.

Deepfakes proberen uit te bannen vindt Gevers geen goed idee. De techniek bestaat al en wordt ook toegepast, en als het hier niet mag dan wel in andere landen. “Ik denk dat je mensen moet informeren over wat mogelijk is, zodat ze het sneller herkennen”, zegt hij.

Waar moet je dan op letten? Kijk vooral naar schaduwpartijen en huidreflecties, aldus Gevers. Het is vaak de belichting die niet helemaal klopt. “Stel ik plak mijn gezicht op dat van een ander, dan is de kans groot dat de belichting anders is”, zegt hij. “Kijk ook naar de ogen. Een deepfake lijkt soms een beetje in de verte te staren of zwenken van links naar rechts, daar gaat het vaak mis.” De techniek kan zelf overigens ook weer helpen om fakes te spotten. “Er zijn wereldwijd misschien zo’n vijftig algoritmes hiervoor. Als je weet hoe die werken, kun je met 95 procent zekerheid zeggen of iets nep is”, zegt Gevers.

Maar het is soms ook gewoon een kwestie van je huiswerk doen en je bronnen checken. Neem een voorval van afgelopen april, toen leden van de Tweede Kamer 25 minuten in een digitale vergadering zaten met een nep-Leonid Volkov, de stafchef van de Russisch oppositieleider Aleksej Navalny. In de media ging het al snel over de deepfake-technologie die hier gebruikt zou zijn, mede op aangeven van de échte Volkov. Volgens Gevers was hier geen sprake van. “Een live face swap is op dit moment niet mogelijk, het was gewoon een dubbelganger die er niet eens op leek. Een grapjas in een badjas”, zegt hij. “Er was daarna veel verwarring en je krijgt de wildste verhalen, ook omdat mensen helemaal niet weten wat wel en niet kan.”