Je hebt het vast al eens een gezien: zo’n ‘badmuts’ met draadjes, op het hoofd van een proefpersoon of patiënt. We gingen langs bij twee labs, waar AI herseninfo van zo’n EEG-muts koppelt aan acties.

Ik draag een badmuts met gaatjes. Vanuit mijn stoel staar ik naar een computerscherm. “Wel recht ervoor zitten”, zegt Jordy Thielen, onderzoeker kunstmatige intelligentie en hersenwetenschap bij het Donders Instituut van de Radboud Universiteit. Hij spuit een kleverige gel tussen mijn haren, de mutsgaatjes in, en drukt er metalen pinnetjes bij. Thielen start een computerprogramma op. Regels met code schieten omlaag. Hij tovert ze weg en drukt op een knop. Een qwertytoetsenbord verschijnt in beeld. Mijn ogen fixeren erop. Maar schieten ook opzij. De kamer is raamloos. “Dat leidt proefpersonen minder af”, zegt Thielen.

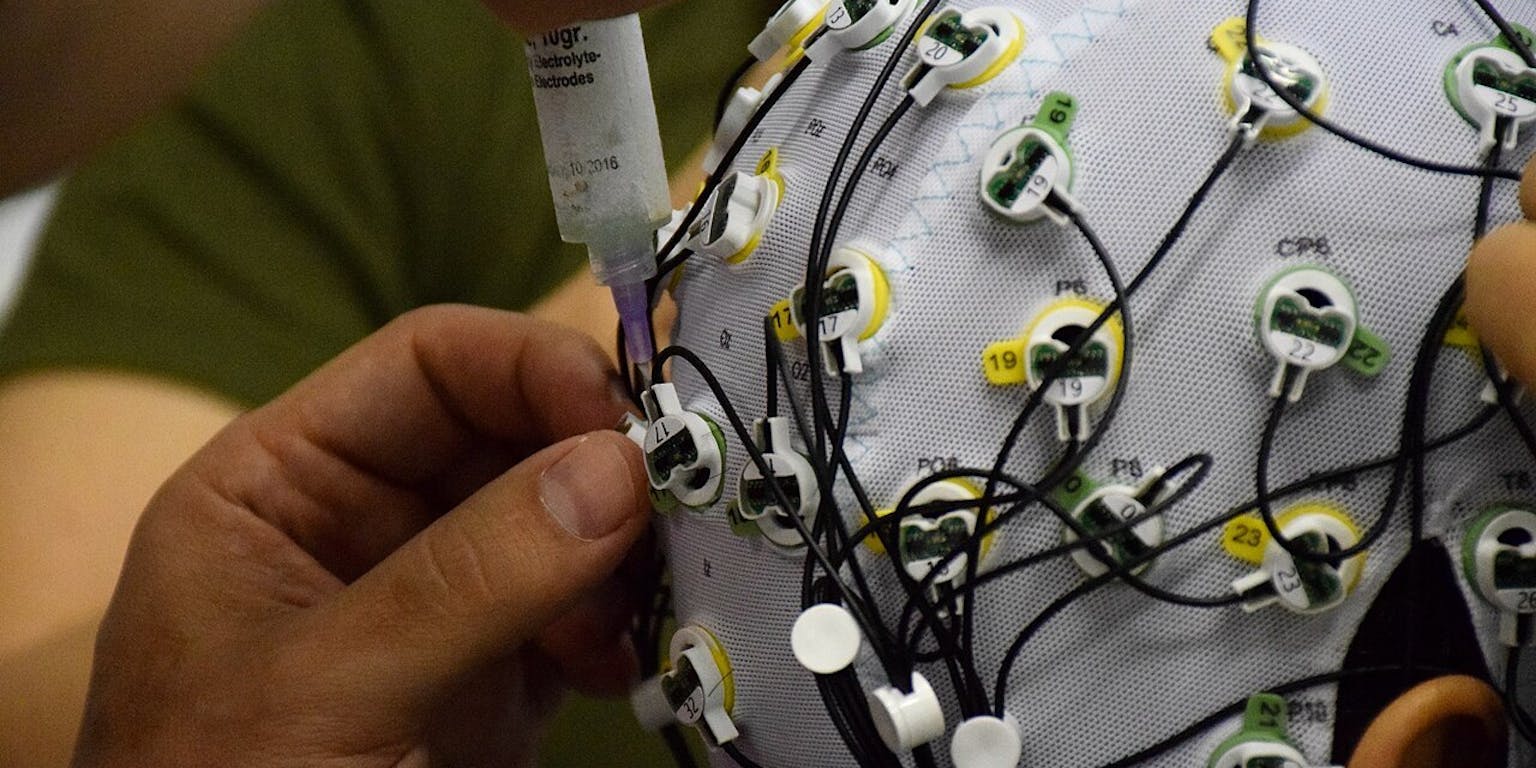

De badmuts is een EEG-muts. De gel een geleider. De metalen pinnetjes zijn elektroden. Die zitten achter op mijn hoofd en meten de elektrische activiteit van mijn visuele cortex: dat hersendeel waar je mee ziet. EEG staat voor elektro-encefalogram. Dat is vrij vertaald zoiets als een hersenfilmpje. Meestal gebruiken neurologen EEG om afwijkingen in de hersenfunctie te detecteren, bijvoorbeeld bij epilepsie. Ik moet er woorden mee typen. Net als mensen met sommige spraakstoornissen dat doen.

Ik staar naar het qwertytoetsenbord op het scherm. “Ben je er klaar voor?”, vraagt Thielen. Hij start de module. Ik kijk naar de N. Terwijl alle letters van het toetsenbord willekeurig oplichten, analyseert de computer mijn hersenactiviteit. Dan de E. Door naar de M. En als laatste de O. Tien seconden later staat er ‘NEMO’ op het scherm. Ook backspace, spaties en hoofdletters werken al. Naast letters kan het systeem zelfs woorden voorspellen.

De welbekende EEG-muts. In de spuit zit een geleidende gel die de elektroden in de muts helpt de zwakke hersensignalen op te pikken.

Niels Olfert“Het werkt net zoals eye-tracking”, zegt Thielen. Daarvoor zijn oogspieren nodig. Tóch experimenteert Thielen met brein-computer interfaces (BCI), waarmee zelfs totaal verlamde mensen met het locked-in syndroom nog kunnen communiceren. De elektroden vangen in dit experiment immers signalen op van de visuele cortex. Dat heeft niks met bewegen te maken. Zolang het beeldscherm met visuele stimuli de aandacht van patiënten trekt, achterhaalt de BCI waar ze naar kijken. Deze BCI-vorm werkt zonder hersenchip en binnen secondes. Via zelflerende algoritmes.

Voordat ik kan typen, moet de computer eerst mijn visuele cortex leren kennen. Het model heeft een korte kalibratie nodig: tien willekeurige letters waar ik één voor één naar kijk, terwijl alle letters in precies hetzelfde vaste flitspatroon voorbij schieten als later tijdens het typen. Ongeveer honderd milliseconden na elke flits registreert de hersenmuts een piek in mijn visuele cortex: het signaal dat ik die letter heb gezien.

Het woord ‘NEMO!!’ typen, door er alleen maar aan te denken; het werkt!

Omdat elke letter anders flitst, ontstaan per letter ook nét andere piekjes. Na die korte kalibratie weet de computer hoe mijn brein reageert op dat unieke patroon. Tijdens het typen vergelijkt hij mijn nieuwe piekjes met de respons die hij tijdens de kalibratie heeft opgeslagen. Vindt hij een match, dan verschijnt de juiste letter op het scherm. Daar heeft hij maar 300 milliseconden aan kalibratiedata voor nodig. De algoritmes zoeken patronen, maken regels, en kunnen daardoor zelfs bij nieuwe input de juiste letter voorspellen.

Zelftrainend systeem

Dat ging vóór AI anders. “Toen was de computer een statisch ding dat zelf niets leerde”, zegt Thielen. De computer ontving via de hersenmuts een signaal uit de motorcortex dat enige tijd boven een bepaalde drempelwaarde uitkwam – bijvoorbeeld wanneer de proefpersoon een spiertje in zijn wang aanspande om een letter te selecteren.

“Het leren zat toen aan de kant van de mens”, legt Thielen uit. “De gebruiker moest zelf leren om zijn hersenactiviteit zó te sturen dat die drempelwaarde werd bereikt.” In Duits onderzoek uit 1999 schreef een proefpersoon op die manier een brief. “Dat kostte zestien uur, twee letters per minuut”, zegt Thielen. En voordat die persoon überhaupt tachtig procent accuraat kon typen met zijn hersenen, waren er al zo’n driehonderd trainingssessies voorbij.

“Nu is dat leren afgeladen naar de computer”, zegt Thielen. En dan nog blijft data ontcijferen lastig. “EEG-signaal is enorm ‘ruizig’”, zegt Thielen. Breinsignalen halen hooguit zo’n één tot twee microvolt. Een simpele ‘oogknipper’ haalt zo’n vijftig keer meer, en veroorzaakt dan al snel ruis. Des te afhankelijker is Thielen dus van machine learning om de juiste hersengolfjes uit de zee van data te pikken. Daarbovenop verandert het breinpatroon van proefpersonen. Als zij vermoeid zijn, bijvoorbeeld, of bij medicatie. Maar ook als de proefpersoon de BCI steeds beter onder de knie krijgt en beter gaat presteren. Thielen: “Wij onderzoeken hoe die algoritmes zich het best kunnen aanpassen aan dat soort veranderingen in de data.”

Thielen ontwikkelde zelfs algoritmes die geen kalibratie meer nodig hebben. De gebruiker wordt dan niet meer gevraagd tien keer naar een bepaalde letter te kijken, maar richt zich direct op de letters die hij zelf wil typen. De eerste letter kost dan misschien nog tien seconden, maar daarna leert het model razendsnel bij: de tweede verschijnt al na zo’n vier seconden. “Het systeem heeft dan een soort warming-up nodig”, zegt Thielen. “Dat kun je weer versnellen door data van vorige sessies of van andere personen te vertalen naar de huidige.”

— Russell ChanAI helpt ons te vinden waar interessante dingen in de datastromen gebeuren

Tóch blijft het oppassen met AI, zegt Thielen. Soms kunnen algoritmes ook patronen vinden op basis van een input-outputpaar, die niet altijd opgaan. “Als er patronen in de kalibratiedataset zitten die het model kan gebruiken om iets op te lossen, dan gaat hij dat waarschijnlijk gebruiken”, zegt Thielen. Ook al legt het algoritme daardoor een foute correlatie, waarmee het op nieuwe data de mist ingaat.

Uiteindelijk wil Thielen de Radboud-BCI buiten het lab gebruiken, zodat mensen er koffie mee kunnen zetten of deuren mee kunnen openen. Net zoals een flitscode een specifieke letter vertegenwoordigt, kan een code ook gekoppeld worden aan een deur of ander object. Kleine ledjes op objecten kunnen die codes flitsen. Zo krijgt elk object als het ware een uniek ‘watermerk’ dat de BCI kan herkennen en met hersenactiviteit kan ‘activeren’.

Een BCI in je rugzak

Het BMS-lab van de Universiteit Twente haalde BCI van achter het toetsenbord naar de echte wereld. De BCI-setup van BMS-lab directeur Jan-Willem van ’t Klooster en neurowetenschapper Russell Chan past gewoon in een rugzak. Vanuit die rugzak verbinden kabels een tablet met de hersenmuts die de gebruiker draagt. Van ’t Klooster en Chan gebruiken hun mobiele BCI-rugzak zowel in de collegezaal als op straat. “Dat zorgt voor meer uitdagingen, maar komt dichter bij het echte leven”, zegt Van ’t Klooster.

Met AI en EEG is het mogelijk om hersensignalen om te zetten naar digitale signalen, die vervolgens allerlei applicaties aan kunnen sturen. Bijvoorbeeld een computerspel of een toetsenbord.

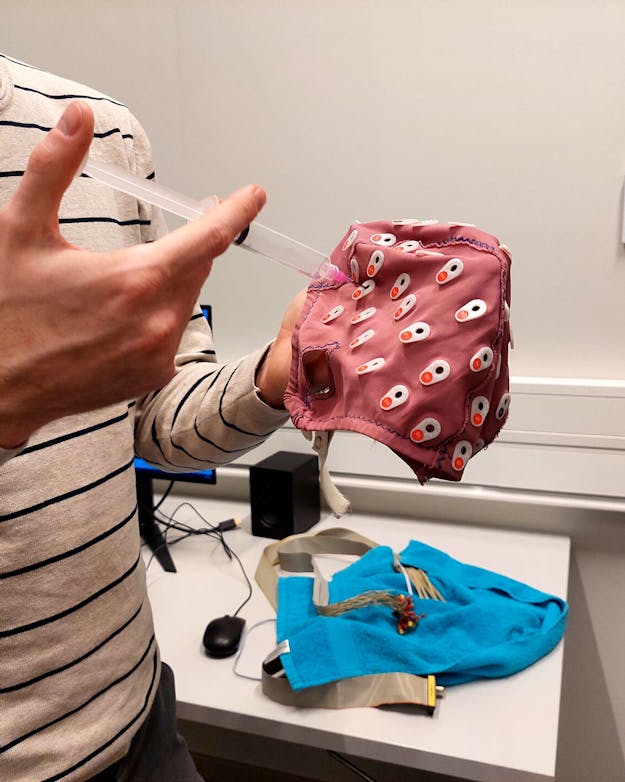

RIDC NeuroMat, CC-by-sa 4.0 via Wikimedia Commons.Ook de Twentse BCI-rugzak werkt met AI. “Algoritmen helpen echt om de signalen op te schonen”, zegt Chan. Ook buiten het lab. “Op een BCI-conferentie zagen we laatst zelfs zuivere breindata van iemand die een backflip maakte.” De BCI uit Enschede werkt niet met flitsjes, maar combineert EEG met fNIRS. Dat laatste staat voor functionele nabij-infrarood spectroscopie. Met nabij-infrarood licht meten neurologen het zuurstofgehalte in het bloed in de hersens. Ledjes op de muts schieten dat licht dwars door de schedel de hersens in. Sensoren op de muts meten hoeveel licht de hersens opnemen.

Als een deel van de hersenen actiever is, gebruikt het meer zuurstof. fNIRS kan dat zuurstofverbruik detecteren. fNIRS is traag, maar laat heel precies zien wáár in de hersenen iets gebeurt. EEG is snel, maar laat minder goed zien waar het signaal vandáán komt. De combinatie geeft ‘het beste van beide werelden’, aldus Van ’t Klooster. De samengestelde hersenmuts meet hoe mensen verschillende stukjes informatie verwerken en ordenen als zij reeksen moeten onthouden. En hoeveel stress en mentale werklast zij daarbij ervaren.

Bijvoorbeeld: nieuwe danspasjes leren vraagt mentale én fysieke inspanning. Datzelfde geldt voor serveren bij tennis. Chan en Van ’t Klooster meten de motoriek van hun proefpersonen bij dit soort taken met extra sensoren: naast de hersenmuts dragen zij traagheidsmeters, oftewel IMU’s. Die zitten op de voeten, onder- en bovenbenen, armen, rond de middel en op het hoofd. IMU’s worden ook in motion-capturepakken gebruikt om menselijke bewegingen voor films en computerspellen vast te leggen.

Voor ik het weet draag ik de BCI-rugzak, de hersenmuts en de traagheidsmetertjes. Het voelt licht en niet log; alsof ik een dagje ga wandelen. Op een scherm volgt een driedimensionale avatar mijn bewegingen. Ik sta op een vierkante mat met vakjes, elk met een pijl die omhoog, omlaag, naar links of naar rechts wijst. Een tv-scherm aan de muur wijst aan op welke pijlen ik achtereenvolgens moet staan. Ik haal het maar tot nummer vijf. Da’s nog niet eens de helft van de module. “Dit is ook een moeilijk niveau”, bekent Chan.

Met AI koppelen Van ’t Klooster en Chan hersen- en bewegingsdata uit het dansprogramma. “AI helpt ons te vinden waar interessante dingen in beide datastromen gebeuren”, verklaart Chan. Om die zoektocht zo snel en nauwkeurig mogelijk te laten verlopen maakt Chan gebruik van voorgetrainde datasets. Daarbij wordt een deel van de verzamelde data – meestal twintig tot dertig procent – apart gehouden om het model te laten voorspellen hoe de rest van de signalen eruit zou moeten zien. Pas daarna gaat het algoritme patronen zoeken en betekenis geven aan de piekjes in de metingen.

De breincomputerinterface van het BMS-lab van de Universiteit Twente is een stuk mobieler, met een EEG-hoofdband rond het hoofd, motion trackers op het lichaam, en een rugzak waar alle apparatuur in zit.

Niels OlfertChan wil met zijn setup motorische achteruitgang bij ouderen tegengaan en zo de zorgdruk verminderen. Het zwaartepunt dat de traagheidsmetertjes meten kan bijvoorbeeld helpen om in revalidatiecentra of fysiopraktijken het valrisico tijdens het bewegen beter te voorspellen. “De hersensignalen vertellen ons of oudere volwassenen tijdens het dansen hun hersenen overbelasten en of ze aanvullende cognitieve training nodig hebben.”

Met AI kan Chan uiteindelijk een neurofenotype ontwikkelen: dat is een soort unieke ‘hersenhandtekening’ die laat zien hoe jouw brein werkt en hoe het in de tijd leert. Kunstmatige intelligentie kan enorme ladingen hersen- en bewegingsdata classificeren, vereenvoudigen en volgen terwijl ze veranderen. Net zoals een personal trainer je nu begeleidt in de sportschool, kan AI straks op basis van je eigen individuele leercurve en hersenactiviteit advies geven: heb je meer oefening nodig met de huidige taak, of ben je klaar voor een moeilijkere stap.